人工智能芯片的竞争:GPU正红,ASIC拥抱未来

本文来自申万宏源研究的研报《人工智能芯片的竞争:GPU正红,ASIC拥抱未来》,作者为证券分析师刘洋。

智通财经APP获悉,申万宏源研究发表研报,对人工智能各类芯片做出分析和对比,内容如下:

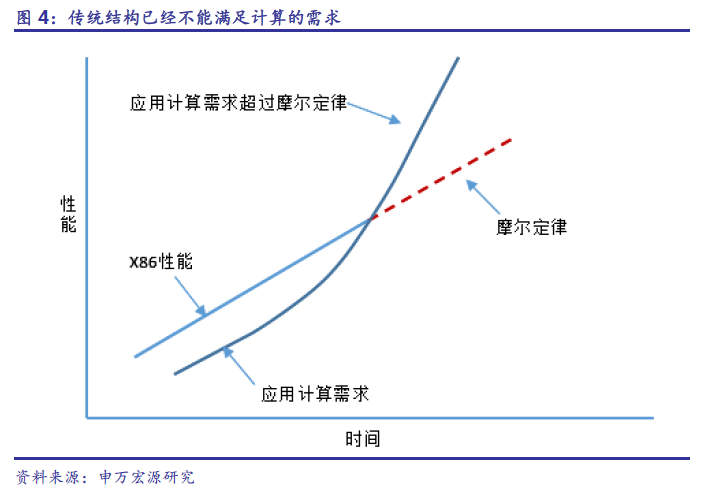

AI加速需求超过CPU计算能力摩尔定律供给

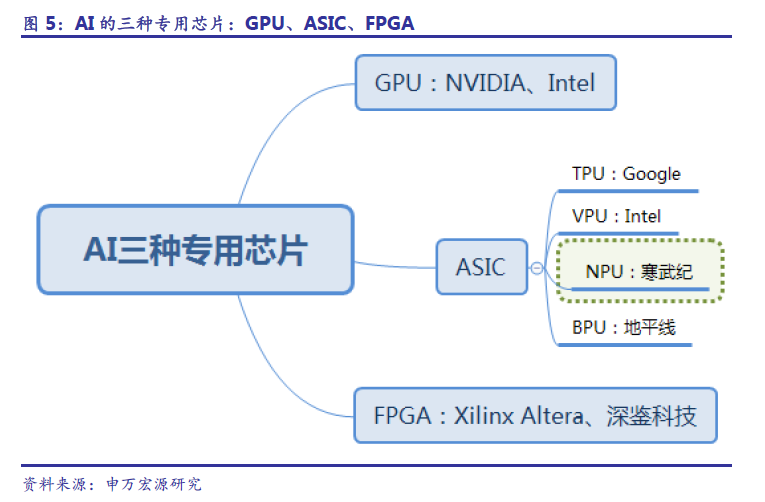

人工智能的三大支撑是硬件、算法和数据,其中硬件指的是运行AI算法的芯片与相对应的计算平台。在硬件方面,目前主要是使用GPU并行计算神经网络,同时,FPGA和ASIC也具有未来异军突起潜能。

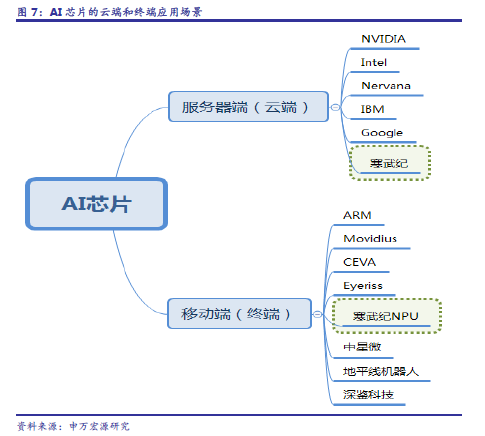

目前AI芯片按照使用场景可以分为:云端(服务器端)和终端(移动端)芯片。云端主要指公有云、私有云、数据中心等需要用到的神经网络专用服务器,终端指手机、车载、安防、音响、机器人等移动应用终端。有的厂商同时具备云端和终端芯片的设计能力。

机器学习不断演进,深度学习出现。人工智能是应用范畴的词汇,机器学习是目前最有效实现人工智能的方法。深度学习是机器学习的子类,也是现有机器学习方法中,最奏效的一类。

深度学习的人工神经网络算法与传统计算模式不同。传统计算机软件是程序员根据所需要实现的功能原理编程,输入至计算机运行即可,其计算过程主要体现在执行指令这个环节。而深度学习的人工神经网络算法包含了两个计算过程:

1. 训练:用已有的样本数据去训练人工神经网络。

2. 执行:用训练好的人工神经网络去运行其他数据。

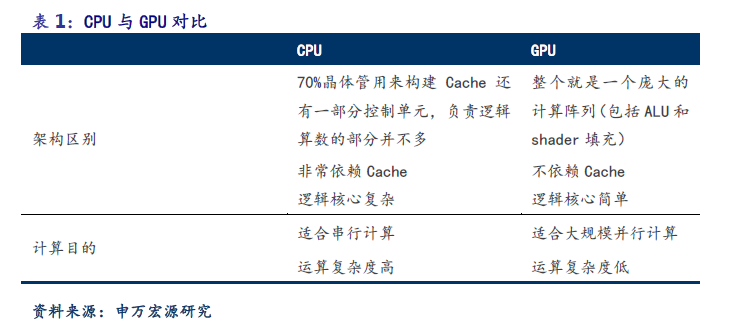

深度学习是目前AI 领域最有效算法,深度学习模型需要通过大量的数据训练才能获得理想的效果,CPU优势为处理各类数据及强逻辑判断能力,解决单次复杂问题能力强。两者需求并非完全匹配,深度学习需要一种替代硬件来满足海量数据的运算需求。

除了CPU以外,AI使用的主流芯片种类有: GPU、FGPA、ASIC。

GPU将最早受益于安防等需求爆发

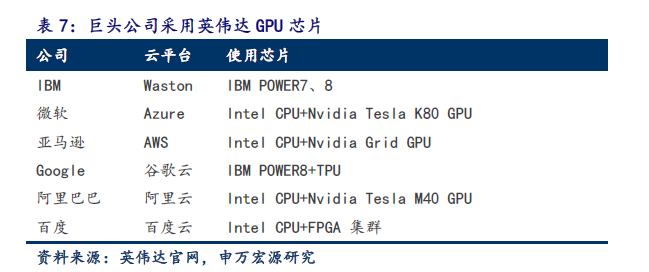

GPU是较成熟生态系统,最先受益人工智能爆发。GPU与CPU类似,只不过是一种专门进行图像运算工作的微处理器。GPU是专为执行复杂的数学和几何计算而设计的,这些计算是图形渲染所必需的。GPU在浮点运算、并行计算等部分计算方面可以提供数十倍乃至于上百倍于CPU的性能。英伟达公司从2006 年下半年已经开始陆续推出相关的硬件产品以及软件开发工具,目前是人工智能硬件市场的主导。

GPU作为图像处理器,设计初衷是为了应对图像处理中需要大规模并行计算。因此,其在应用于深度学习算法时,有三个方面的局限性:

1. 应用过程中无法充分发挥并行计算优势。深度学习包含训练和应用两个计算环节,GPU在深度学习算法训练上非常高效,但在应用时一次性只能对于一张输入图像进行处理,并行度的优势不能完全发挥。

2. 硬件结构固定不具备可编程性。深度学习算法还未完全稳定,若深度学习算法发生大的变化,GPU 无法像FPGA 一样可以灵活的配置硬件结构

3. 运行深度学习算法能效远低于FPGA。学术界和产业界研究已经证明,GPU计算方式与深度学习算法并非完全匹配,性能峰值无法被完全利用。运行深度学习算法中实现同样的性能,GPU所需功耗远大于FPGA。

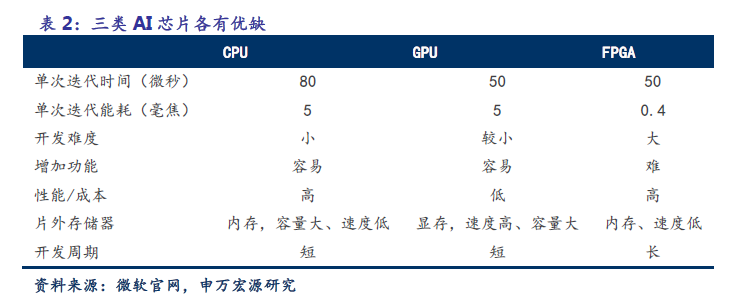

FPGA:能效居中的中间方案

FPGA是能效中等、灵活度高、成本较高的AI白板。FPGA称为现场可编程门阵列,用户可以根据自身的需求进行重复编程。FPGA比GPU具有更低的功耗,比ASIC具有更短的开发时间和更低的成本。目前来看,FPGA在两个领域的应用前景十分巨大:工业互联网领域、工业机器人设备领域。

作为未来制造业发展的方向,工业大数据、云计算平台、MES系统等都是支持工业智能化的重要平台,它们需要完成大数据量的复杂处理,FPGA在其中可以发挥重要作用。

FPGA与GPU、CPU相比,具有性能高、能耗低、可硬件编程的特点。尽管FPGA 倍受看好,甚至新一代百度大脑也是基于FPGA 平台研发,微软、IBM 等公司都有专门的FPGA团队为服务器加速,但其毕竟不是专门为了适用深度学习算法而研发,实际仍然存在不少局限:

1. 基本单元的计算能力有限。为了实现可重构特性,FPGA 内部有大量极细粒度的基本单元,但是每个单元的计算能力(主要依靠LUT 查找表)都远远低于CPU和GPU中的ALU模块。

2. 速度和功耗有待提升。相对专用定制芯片ASIC,FPGA 在处理速度和功耗方面仍然存在不小差距。

3. FPGA价格相对较为昂贵。在规模放量的情况下单块FPGA 的成本要远高与ASIC,因此FPGA 更适用于企业级用户,尤其是重配置、性能需求较高的军工和工业电子领域。

ASIC:能效顶级、拥抱未来

ASIC 是一种为专门目的而设计的集成电路,功能特定的最优功耗AI 芯片,专为特定目的而设计。不同于GPU 和FPGA 的灵活性,定制化的ASIC一旦制造完成将不能更改,所以初期成本高、开发周期长的使得进入门槛高。目前,大多是具备AI 算法又成就梦想擅长芯片研发的巨头参与,如Google的TPU。

ASIC 的另一个未来发展是类脑芯片。类脑芯片是基于神经形态工程、借鉴人脑信息处理方式,适于实时处理非结构化信息、具有学习能力的超低功耗芯片,更接近人工智能目标。由于完美适用于神经网络相关算法,ASIC在性能和功耗上都要优于GPU FPGA,TPU1 是传统GPU性能的14-16倍,NPU是GPU的118 倍。寒武纪已发布对外应用指令集,预计ASIC将是未来AI 芯片的核心。

GPU在训练层应用广泛,ASIC在执行层表现较好。GPU、TPU 和NPU,适合的人工智能操作也不同。不同种类的芯片适用于不同的场景。

寒武纪终端闪耀、云端推进

目前AI芯片按照使用场景可以分为:云端(服务器端)和终端(移动端)芯片。云端AI芯片类似于超级计算机,终端AI芯片更偏重能耗。先发优势与浮点计算峰值决定GPU目前在云端处于主导地位。

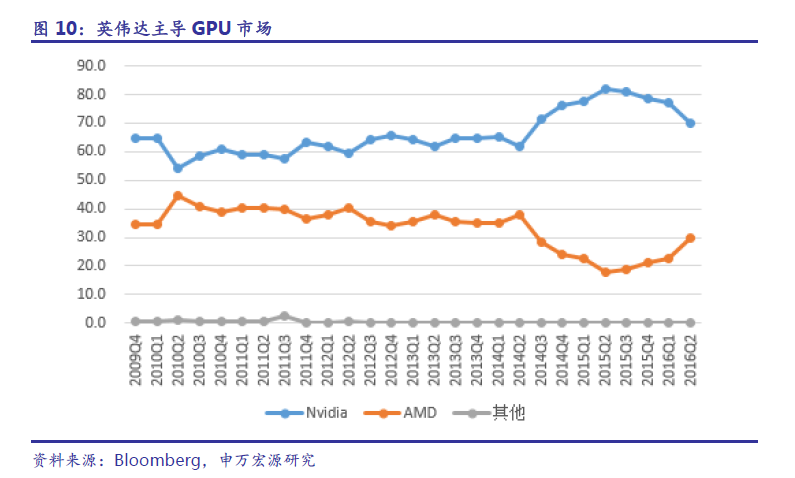

产品持续迭代,英伟达垄断GPU市场。英伟达占据全球GPU超过70%的市场份额,GPU产品占据公司2016年84%的收入来源。

寒武纪在ASIC全面领先,指令集是杀手锏创新,终端应用逐步增强,NPU已形成事实上落地。

手机是最重要的移动终端产品,苹果的iPhone X采用的A11就是基于神经网络的芯片“Bionic 神经引擎”,其Face ID的面部数据都由该芯片处理。华为于2017年9月发布了全球首款移动端AI 芯片麒麟970,并应用在Mate 10手机中,这是华为和寒武纪深度合作,集成了专用于神经网络的NPU。

根据华为公布的测试数据,在处理相同的AI应用任务时,麒麟970的HiAI异构计算架构拥有大约50倍能效和25倍性能优势。9月4日,有媒体披露了中科院发给华为的贺信,称寒武纪公司研制并具有自主知识产权的“寒武纪1A深度学习处理器”,在人工智能应用上达到了4核CPU25倍以上的性能和50倍以上的能效。此次,麒麟970芯片集成寒武纪1A处理器作为其核心人工智能处理单元,实现了手机上本地、实时、高效的智能处理。(编辑:胡敏)

扫码下载智通APP

扫码下载智通APP