英伟达(NVDA.US)AI盛会GTC揭幕,最强AI芯片Blackwell来了!

号称今年全球头号人工智能(AI)领域开发者大会的英伟达2024 GTC AI大会于美东时间3月18日周一拉开帷幕。

今年是英伟达时隔五年首次让年度GTC重回线下,也是此前分析认为英伟达要“拿出点真家伙”的AI盛会。

当地时间周一下午,英伟达创始人兼CEO 黄仁勋在美国加州圣何塞SAP中心进行主题为“面向开发者的1#AI峰会”(1# AI Conference for Developers)演讲。

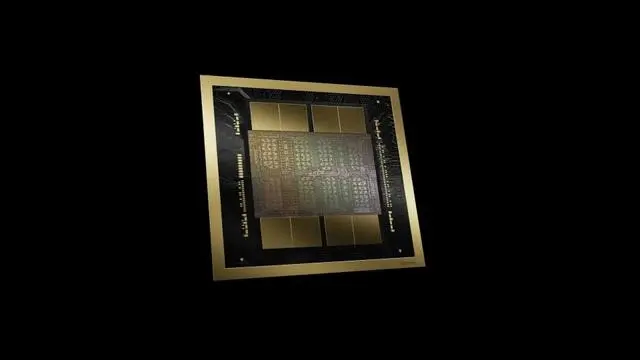

Blackwell成本和能耗较前代改善25倍 全球最强大芯片 台积电4 nm制程

黄仁勋介绍了运行AI模型的新一代芯片和软件。英伟达正式推出名为Blackwell的新一代AI图形处理器(GPU),预计将在今年晚些时候发货。

Blackwell平台能够在万亿参数级的大型语言模型(LLM)上构建和运行实时生成式 AI,而成本和能耗比前代改善25倍。

英伟达称,Blackwell拥有六项革命性的技术,可以支持多达10万亿参数的模型进行AI训练和实时LLM推理:

全球最强大的芯片:Blackwell 架构 GPU由 2080 亿个晶体管组成,采用量身定制的台积电4纳米(nm)工艺制造,两个reticle极限GPU裸片将10 TB/秒的芯片到芯片链路连接成单个统一的GPU 。

第二代 Transformer引擎:结合了Blackwell Tensor Core技术和TensorRT-LLM和 NeMo Megatron 框架中的 英伟达先进动态范围管理算法,Blackwell 将通过新的4位浮点AI 支持双倍的计算和模型大小推理能力。

第五代 NVLink:为提高数万亿参数和混合专家AI 模型的性能,最新一代英伟达NVLink为每个 GPU 提供了突破性的 1.8TB/s 双向吞吐量,确保最复杂LLM之间多达576 个GPU 之间的无缝高速通信。

RAS 引擎 :Blackwell 支持的 GPU 包含一个专用引擎,实现可靠性、可用性和服务性。 此外,Blackwell 架构还增加了芯片级功能,利用基于AI的预防性维护进行诊断和预测可靠性问题。这可以最大限度地延长系统正常运行时间,并提高大部署规模AI的弹性,使其能连续运行数周甚至数月,并降低运营成本。

安全人工智能:先进的机密计算功能可在不影响性能的情况下保护AI模型和客户数据,并支持新的本机接口加密协议,这对于医疗保健和金融服务等隐私敏感行业至关重要。

解压缩引擎:专用解压缩引擎支持最新格式,加快数据库查询,提供数据分析和数据科学的最高性能。 未来几年,在企业每年花费数百亿美元的数据处理方面,将越来越多地由 GPU 加速。GB200 NVL72推理性能较H100提升高达30倍

英伟达同时介绍超级芯片GB200 Grace Blackwell Superchip,它通过 900GB/s的超低功耗NVLink,将两个B200 Tensor Core GPU 连接到NVIDIA Grace CPU。

为了获得最高的 AI 性能,GB200 驱动的系统可以与周一同时宣布的英伟达Quantum-X800 InfiniBand 和 Spectrum-X800 以太网平台连接,这些平台可提供速度高达 800Gb/s 的高级网络。

GB200是英伟达GB200 NVL72 的关键组件,GB200 NVL72 是一种多节点、液冷、机架规模系统,适用于计算最密集的工作负载。 它结合了 36 个 Grace Blackwell 超级芯片,其中包括通过第五代 NVLink 互连的 72 个 Blackwell GPU 和 36 个 Grace CPU。GB200 NVL72 还包括 NVIDIA BlueField®-3 数据处理单元,可在超大规模 AI 云中实现云网络加速、可组合存储、零信任安全性和 GPU 计算弹性。

相比数量的H100 Tensor Core GPU 相比,GB200 NVL72 对于 LLM 推理工作负载的性能提升高达 30 倍,并将成本和能耗降低高达 25 倍。

GB200 NVL72平台充当单个 GPU具有 1.4 exaflops 的 AI 性能和 30TB 的快速内存,是最新 DGX SuperPOD 的构建块。

英伟达推出服务器主板HGX B200,它通过 NVLink 连接八个 B200 GPU,以支持基于 x86 的生成式 AI 平台。 HGX B200 通过英伟达Quantum-2 InfiniBand 和 Spectrum-X 以太网网络平台支持高达 400Gb/s 的网络速度。

亚马逊、微软、谷歌和甲骨文在首批提供Blackwell支持的云服务商之列

Blackwell芯片将成为亚马逊、微软、谷歌这类全球最大数据中心运营商部署新电脑和其他产品的基础。基于Blackwell的产品将在今年晚些时候问世。

英伟达称,亚马逊云AWS、谷歌云、微软云Azure 和甲骨文云基础设施Oracle Cloud Infrastructure将成为首批提供Blackwell支持实例的云服务提供商,英伟达云合作伙伴计划的成员公司Applied Digital、CoreWeave、Crusoe、IBM Cloud 和 Lambda 也将成为首批提供 Blackwell 实例的云服务提供商。

面向主权的Sovereign AI 云还将提供基于 Blackwell 的云服务和基础设施,包括 Indosat Ooredoo Hutchinson、Nebius、Nexgen Cloud、Oracle欧盟主权云、Oracle 美国、英国和澳大利亚政府云、Scaleway、Singtel、Northern Data Group 的 Taiga Cloud、 Yotta Data Services 的 Shakti Cloud 和 YTL Power International。

黄仁勋说,“三十年来,我们一直在追求加速计算,目标是实现深度学习和AI这类方面的变革性突破。生成式AI是我们这个时代的决定性技术。 Blackwell是推动这场新工业革命的引擎。 通过与世界上最具活力的公司合作,我们将实现AI在各行各业的承诺。”

英伟达在公告通稿中列举了料将采用Blackwell的一些组织,比如微软、亚马逊、谷歌、Meta、戴尔、OpenAI、甲骨文、马斯克领导的特斯拉和 xAI。黄仁勋介绍了包括这些公司在内的更多合作伙伴。

黄仁勋还提到,台积电和Synopsys将采用英伟达计算光刻技术,起用英伟达的计算光刻平台CuLitho。

台积电和Synopsys已经整合英伟达的Culitho W软件。他们将用英伟达的下一代 Blackwell GPU 来实现AI 和 HPC 应用。

新软件NIM让用户更容易利用已有英伟达GPU进行AI推理

英伟达同时宣布推出名为英伟达NIM的推理微服务,它是优化的云原生微服务,旨在缩短生成式 AI 模型的上市时间并简化它们在云、数据中心和 GPU 加速工作站上的部署。

英伟达NIM通过使用行业标准 API 抽象化 AI 模型开发和生产包装的复杂性来扩展开发人员库。它是英伟达AI Enterprise 的一部分,为开发 AI 驱动的企业应用程序和在生产中部署 AI 模型提供了简化的路径。

NIM让用户使用旧版英伟达GPU进行推理或运行AI软件的过程变得更容易,并允许企业客户继续用他们已有的英伟达GPU。推理所需的算力比最初训练新的AI模型的少。 NIM 让企业能运行自己的AI 模型,而不是从OpenAI 等公司购买AI的成果。

基于英伟达服务器的客户只要订阅英伟达AI Enterprise 就可使用NIM,每个GPU每年的许可费用为 4500 美元。

英伟达将与微软和Hugging Face 等AI公司合作,确保他们的AI模型能够在所有兼容的英伟达芯片上运行。使用NIM的开发者可以在自己的服务器或基于云的 英伟达服务器上高效地运行模型,而无需冗长的配置过程。

评论称,NIM这种软件让部署AI变得更容易,不但为英伟达创收,而且给客户提供了又一个坚持使用英伟达芯片的理由。

本文选编自“华尔街见闻”,作者: 李丹;智通财经编辑:何钰程。

扫码下载智通APP

扫码下载智通APP